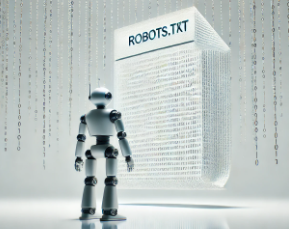

El robots.txt, ubicado en la raíz de tu dominio, puede ser el guardián de tu arquitectura SEO o el responsable de una caída catastrófica en tu tráfico orgánico. Con la proliferación de crawlers de IA, motores semánticos y zero-click SERPs, su correcta configuración es más crítica que nunca.

¿Qué es el archivo robots.txt?

robots.txt es un archivo que indica a los crawlers qué partes de tu sitio pueden o no pueden rastrear. No controla la indexación directamente, sino el acceso. Esta distinción es clave: bloquear el rastreo no impide que una URL sea indexada si otros sitios la enlazan.

¿Para qué sirve robots.txt?

1. Controlar el crawl budget

En sitios grandes, permite priorizar qué se rastrea y qué no, optimizando el presupuesto de rastreo de Googlebot.

2. Proteger áreas sensibles

Evita que se rastreen zonas como /checkout/, /admin/, /search/, que no aportan valor SEO.

3. Evitar contenido duplicado

Bloquea rutas que generan duplicidad, como filtros, parámetros o versiones internas.

4. Mejorar la eficiencia del rastreo

Al reducir ruido, se facilita que Google rastree e indexe lo que realmente importa.

¿Por qué es importante en SEO técnico?

Impacto directo en la indexación

Aunque no controla la indexación, sí determina qué contenido puede ser evaluado por los bots.

Prevención de errores críticos

Una mala configuración puede bloquear todo el sitio (Disallow: /) y eliminarlo del índice.

Compatibilidad con arquitectura semántica

Permite reforzar silos temáticos al bloquear rutas irrelevantes y priorizar contenido estratégico.

Mejora del rendimiento orgánico

Un sitio bien rastreado es un sitio bien posicionado. Robots.txt es el primer filtro.

¿Cuándo aplicarlo?

Al lanzar un nuevo sitio

Es esencial definir qué se rastrea desde el inicio para evitar indexación innecesaria.

En migraciones o rediseños

Evita que se rastreen entornos de staging, rutas temporales o duplicadas.

En ecommerce y marketplaces

Controla el rastreo de filtros, variantes y rutas que no aportan valor semántico.

En estrategias de internacionalización

Permite segmentar el rastreo por país, idioma o subdominio.

Desventajas de no aplicarlo correctamente

Bloqueo total del sitio

Un Disallow: / mal ubicado puede eliminar todo el contenido del índice.

Rastreo de contenido irrelevante

Sin restricciones, los bots pueden gastar crawl budget en rutas sin valor SEO.

Indexación de duplicados

Filtros, parámetros y versiones internas pueden generar contenido duplicado y penalizaciones.

Pérdida de control semántico

Sin robots.txt, se pierde la capacidad de guiar a los bots por la arquitectura temática.

Directivas clave y su uso estratégico

- User-agent:Define el bot al que se aplican reglas (por ejemplo; User-agent: Googlebot)

- Disallow:Bloquea el rastreo de una ruta (por ejemplo; Disallow: /checkout/)

- Allow:Permite el rastreo de una ruta (por ejemplo; Allow: /blog/)

- Sitemap:Indica la ubicación del sitemap (por ejemplo; Sitemap: https://site.com/sitemap.xml)

- Crawl-delay:Establece tiempo entre rastreos (por ejemplo; Crawl-delay: 2)

- Host:Define el dominio principal (por ejemplo; Host: www.site.com)

Nota crítica: Un error como Disallow: / bajo User-agent: * puede bloquear todo el sitio y destruir años de posicionamiento.

Cómo optimizar robots.txt sin sabotear tu SEO (Buenas prácticas):

- Validar con Google Search Console.

- Usar User-agent específicos para bots relevantes (Googlebot, Bingbot).

- No bloquear recursos críticos (CSS, JS) que afectan el renderizado.

- Integrar Sitemap: para facilitar la indexación.

- Evitar directivas ambiguas o mal escritas (Disallow: sin ruta, uso incorrecto de * o $).

El archivo robots.txt es más que una herramienta técnica: es tu firewall semántico, tu gestor de crawl budget y tu escudo contra errores catastróficos. Su correcta implementación permite escalar con precisión, proteger tu arquitectura y maximizar el rendimiento orgánico.